一些implement 神经网络的代码

dense:fully connected layed

input layer:

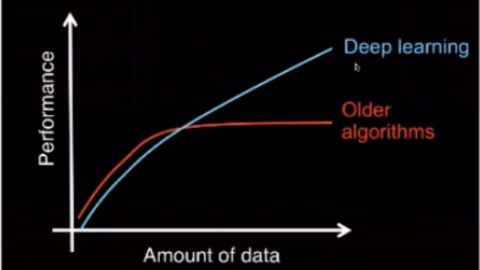

NN: fully connected, hyperparameter,神经元数量,需要自己tune,数据量少,HP可以稍微少点,避免overfit。根据train performance和test performance 来tune 超参数:learning curve。 中间几层layer也算是超参数

output: 和prediction size一样,softmax函数,

compile network: 选择optimization方法:Adam和rmsprop,确定loss function, 选择metrica,训练的时候会print accuracy。

train——image的pre_processing:reshape,pixel value从0到1(input normalization)。

把label定义,one-hot encoding,从一味矩阵变成10*10

开始train网络,epoch=5轮,每组6万张图片,(每张图片训练5次)总共数据量30万次。batchsize:6万丈中每次选择128张一块训练求出y值,然后加起来128个之后总共backward propagation。